在llama3模型部署时,会遇到一系列问题,这里就作者所遇到的问题与解决方法分享一下。

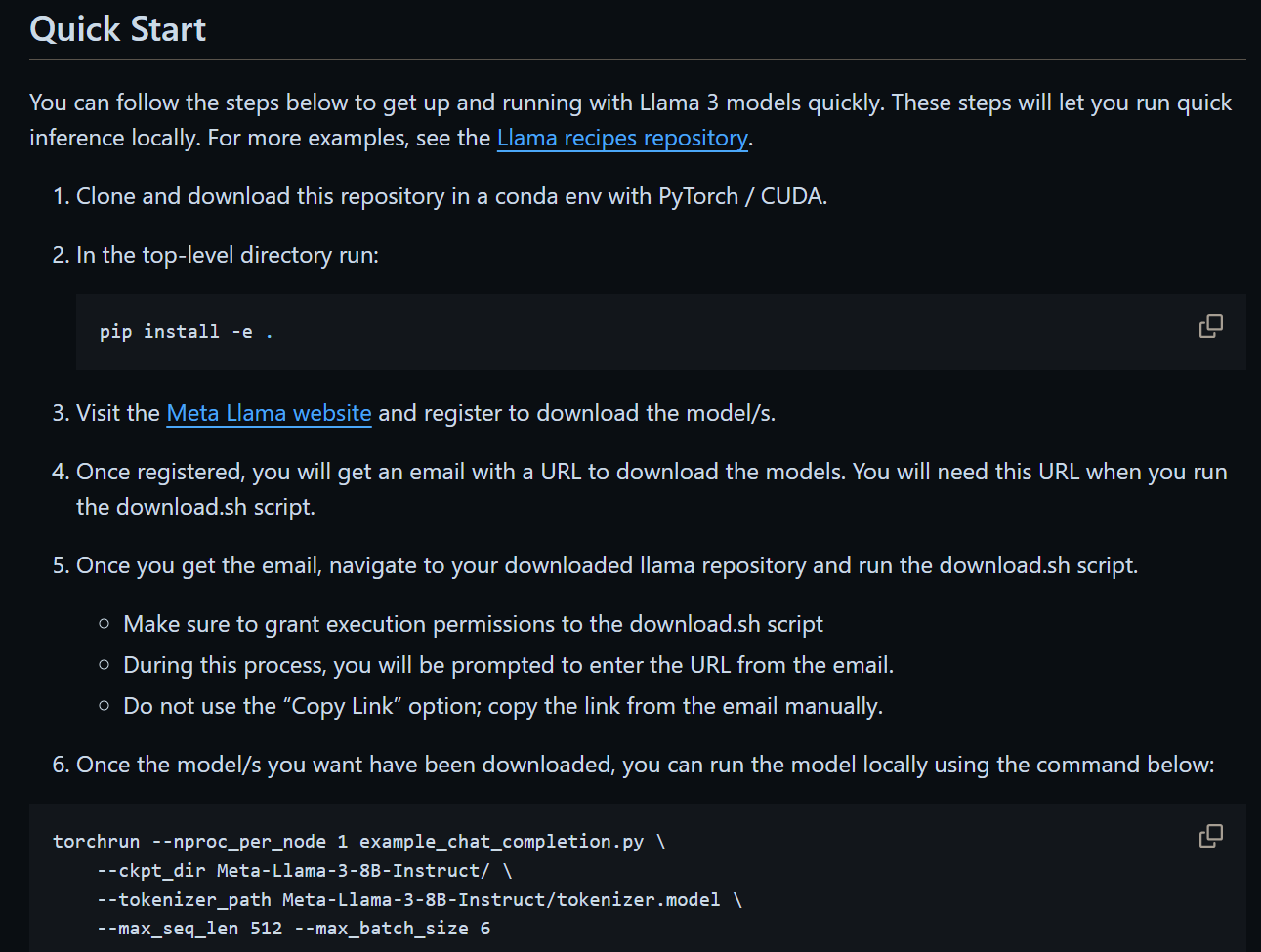

注意:这里是从llama3 github主页上给的方法一步步做的,不适用于其他部署大模型的方法。

文章目录

- ERROR 403:Forbidden

- 安装依赖时出错

- cuda与pytorch版本不一致问题

- 模型成功运行截图

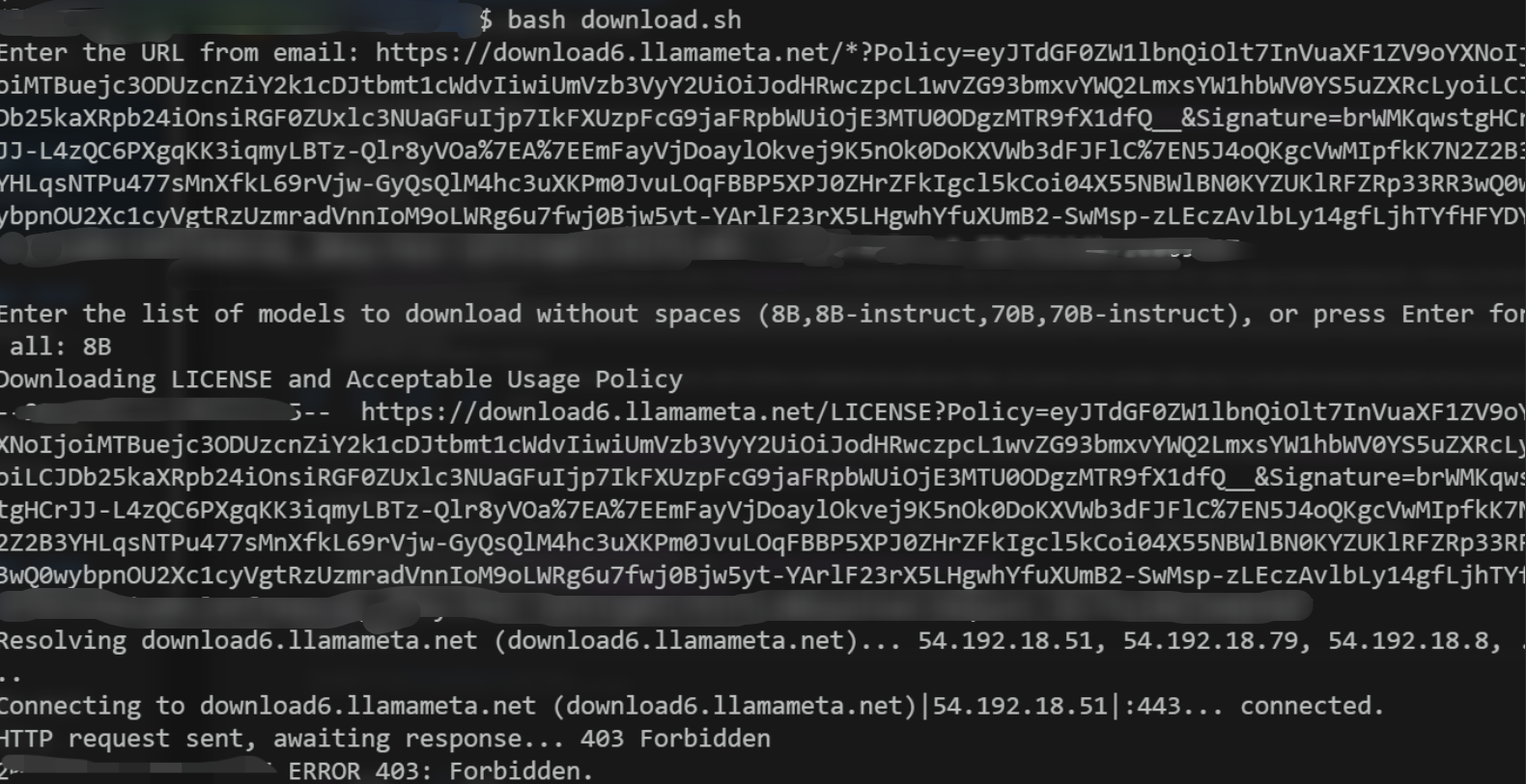

ERROR 403:Forbidden

原因:在模型下载时本地IP或代理IP被服务器ban掉

解决方法:使用科学方法,一个节点一个节点去试;或者换用国内的镜像源:魔塔社区

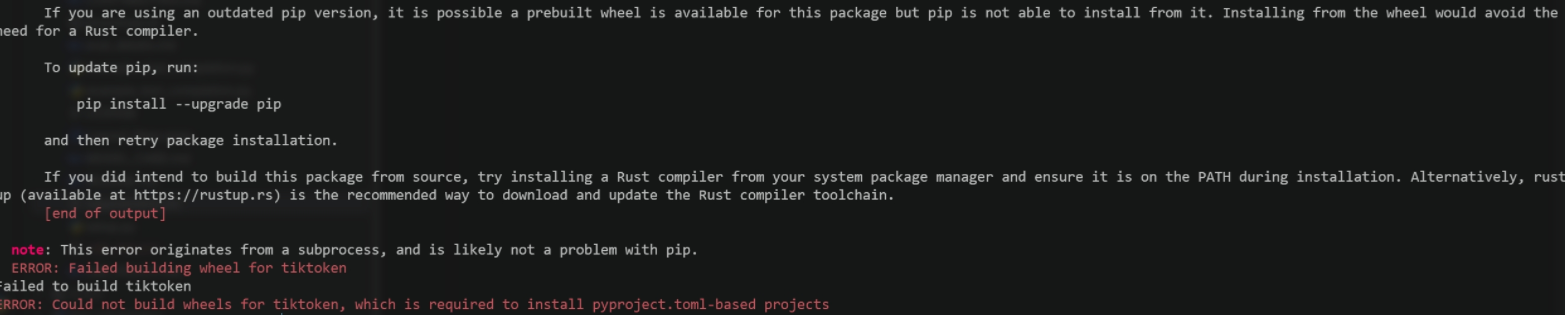

安装依赖时出错

原因:系统没有安装Rust编译器

解决方法:安装cargo,里面包含了所需的Rust编译工具和其他一些工具

cuda与pytorch版本不一致问题

原因:cuda与pytorch版本不一致

解决方法:在pytorch官网上查询对应版本,重新安装版本一致的pytorch或cuda

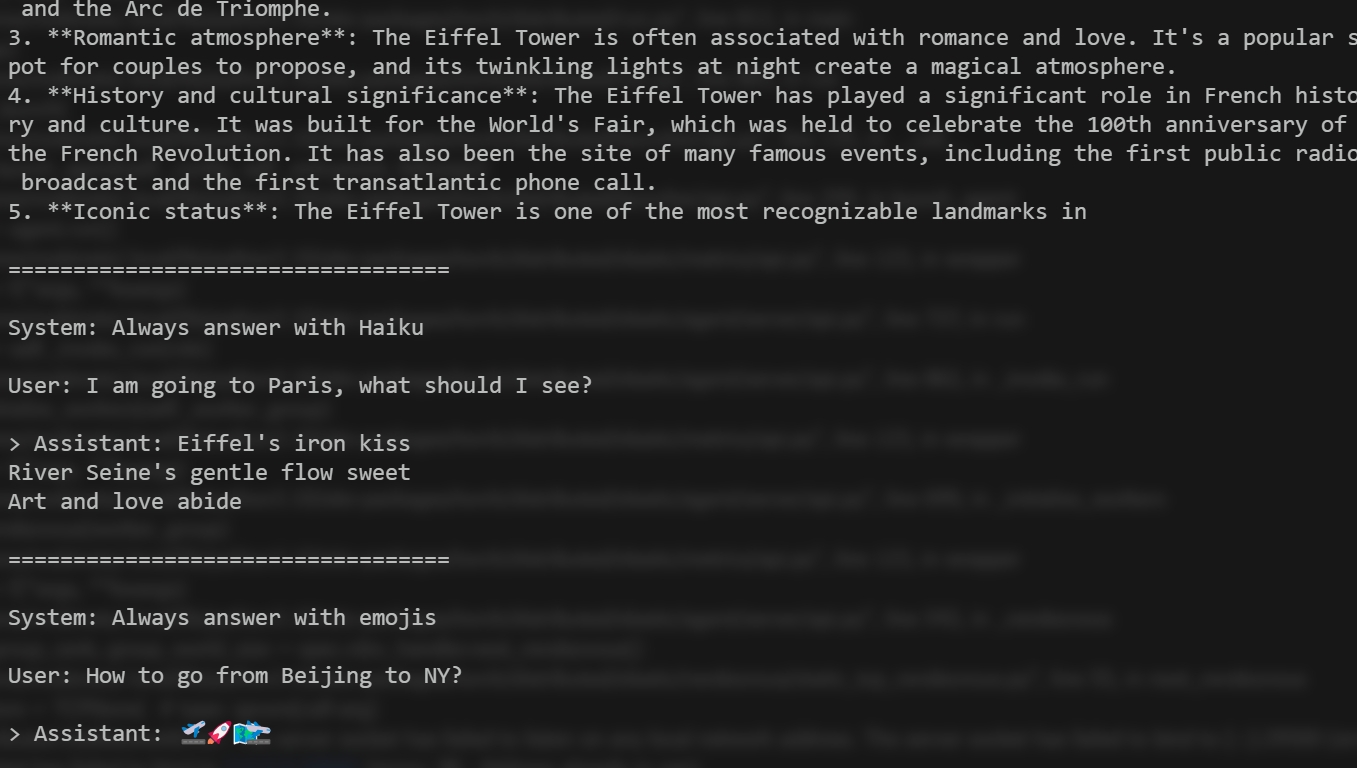

模型成功运行截图

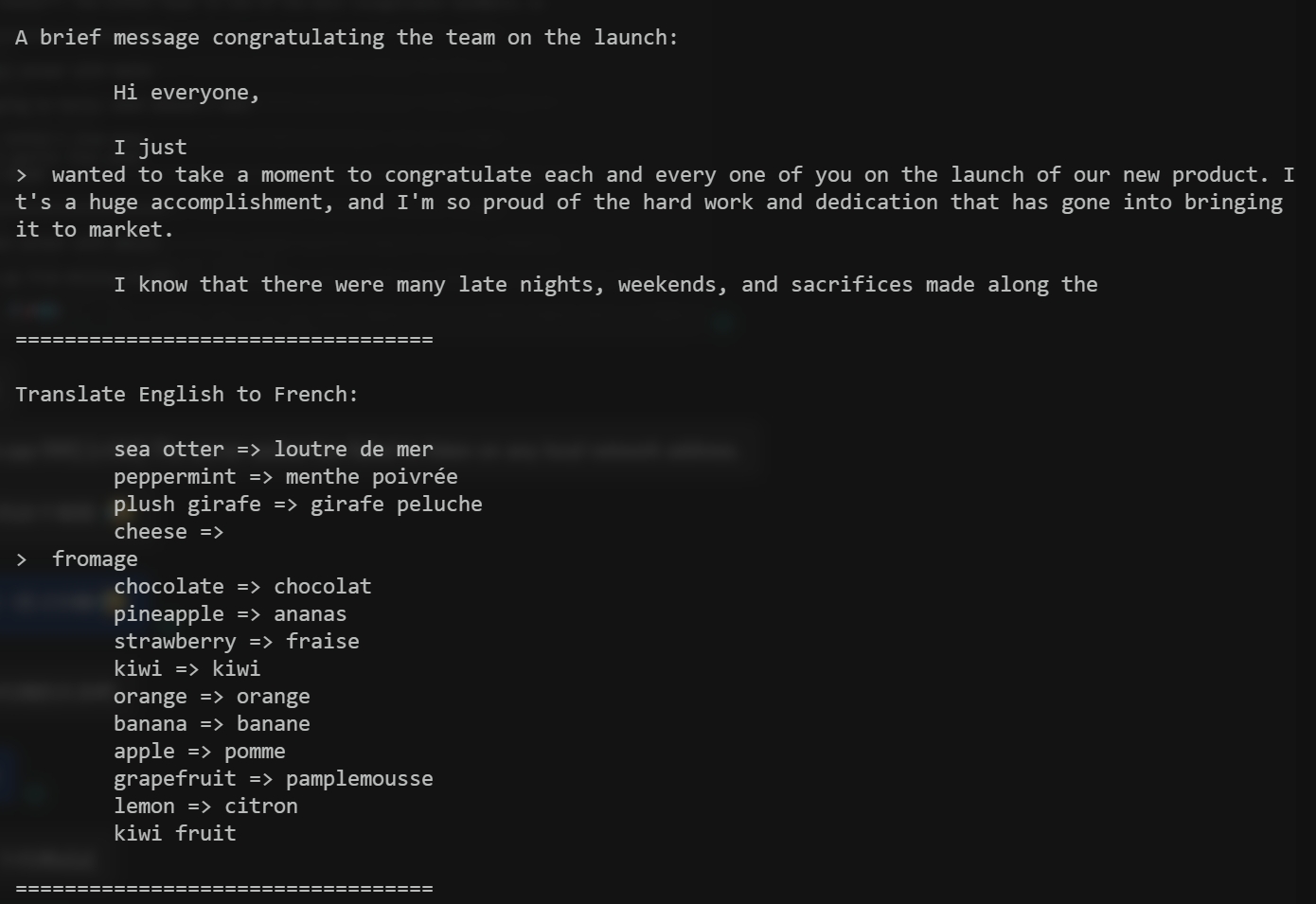

example_chat_completion.py

example_text_completion.py