前言

上一篇文章,讲了DeepSeek-R1部署到本地的方法。这一篇文章,我们让DeepSeek再一次升级,通过图形化界面来交互,从而变成我们的AI助理,让DeepSeek R1发挥最大实力!

首选需要借助硅基流动的API接口,体验满血复活版的R1!还没有注册的去注册一下:

# 硅基流动API接口

https://cloud.siliconflow.cn/i/2Gy74qB6

文档目的

当前文档主要目的是构建本地化AI助理,实现无网络和有网络也能够使用本地AI,并训练成为你的私人助理。由于当前文档仅作为演示,在最后本地化知识库搭建时,只需要上传文档后,再根据不同的文档进行提问进行训练。为提高DeepSeek响应速度,最好使用GTX 4060及以上显卡进行训练。

不同类型DeepSeek需求类型

注意:虽然此处写着不同级别的模型对应着不同的CPU、内存、硬盘核显卡等需求。但个人部署时不一定需要这个,硬件设备过低会影响计算效果,但偏差不会很大。可用于本地知识库搭建。

环境配置信息

智能助理来时的路

1、Linux安装 DeepSeek

注意:当前文档将不再演示Linux安装DeepSeek,请参照我之前的文档进行配置。

# Linux安装DeepSeek步骤

https://www.modb.pro/db/1887709942350622720

联网配置

注意:目前本地化DeepSeek需要联网,必须安装DeepSeek:14b大模型,通过使用火狐+Page Assist插件完成本地化Deekseek访问互联网

1、下载火狐浏览器

# 火狐浏览器下载地址

https://www.firefox.com.cn/

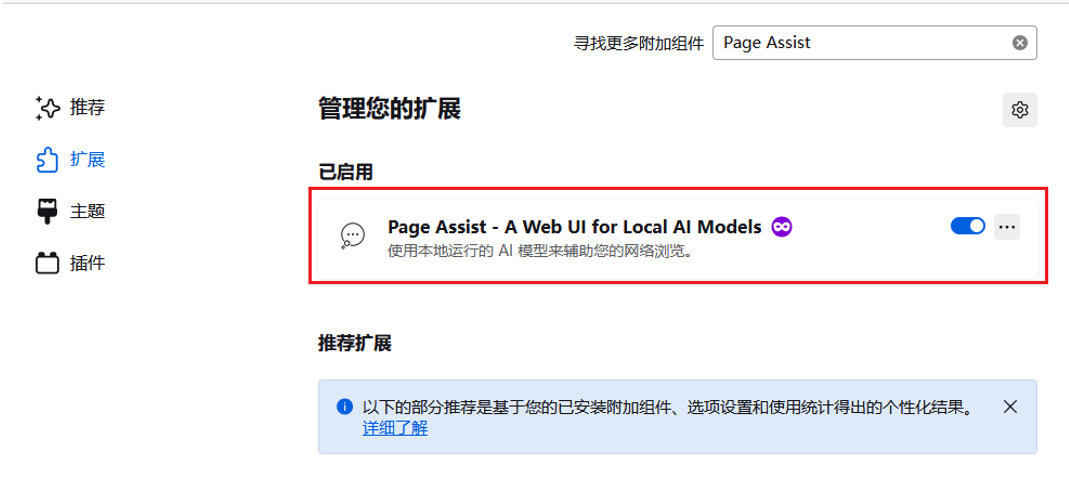

2、火狐下载Page Assist – A Web UI for Local AI Models插件

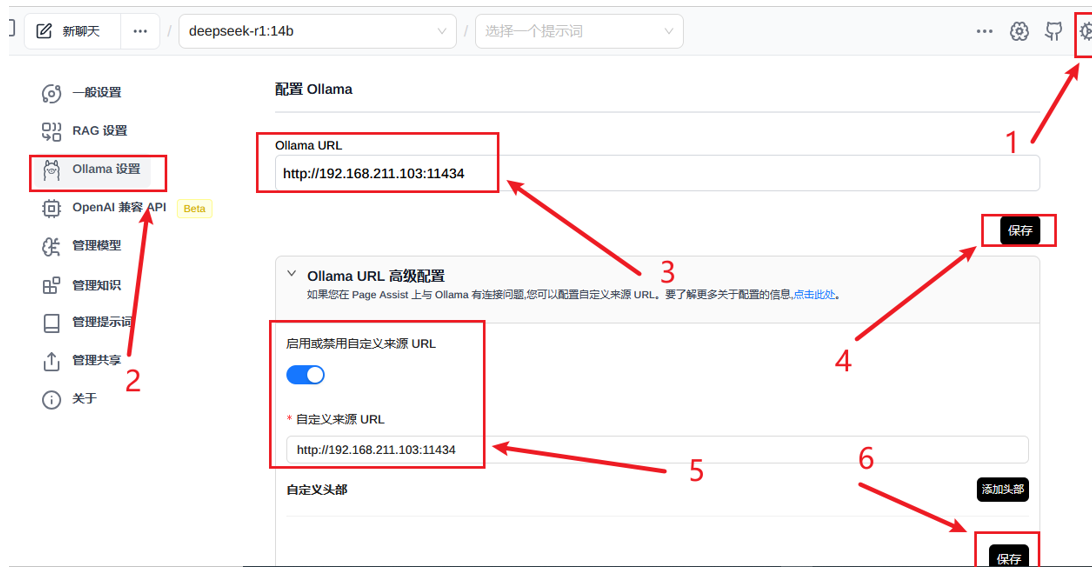

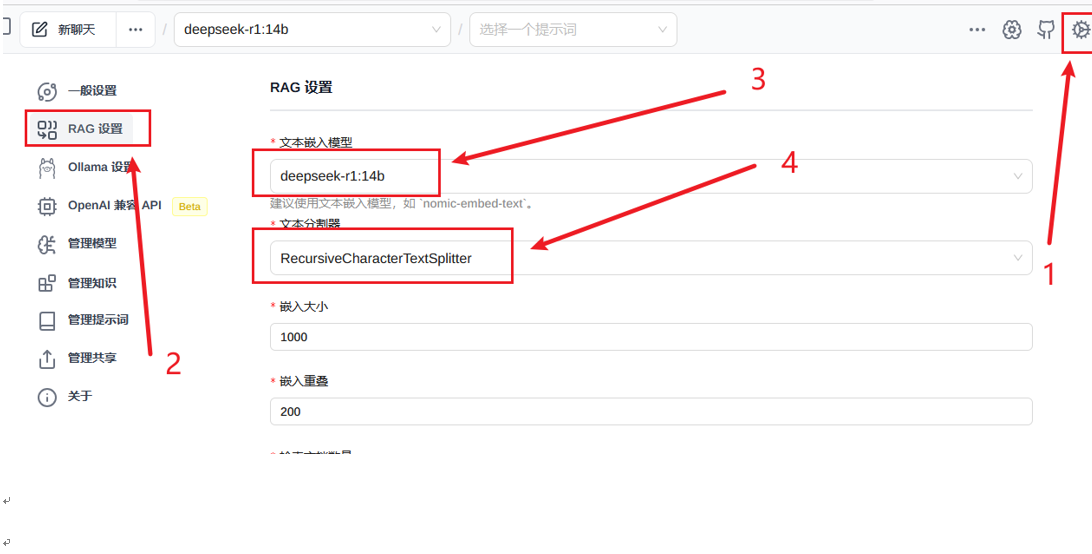

3、插件设置

注意:请根据箭头号所标注的数字进行配置

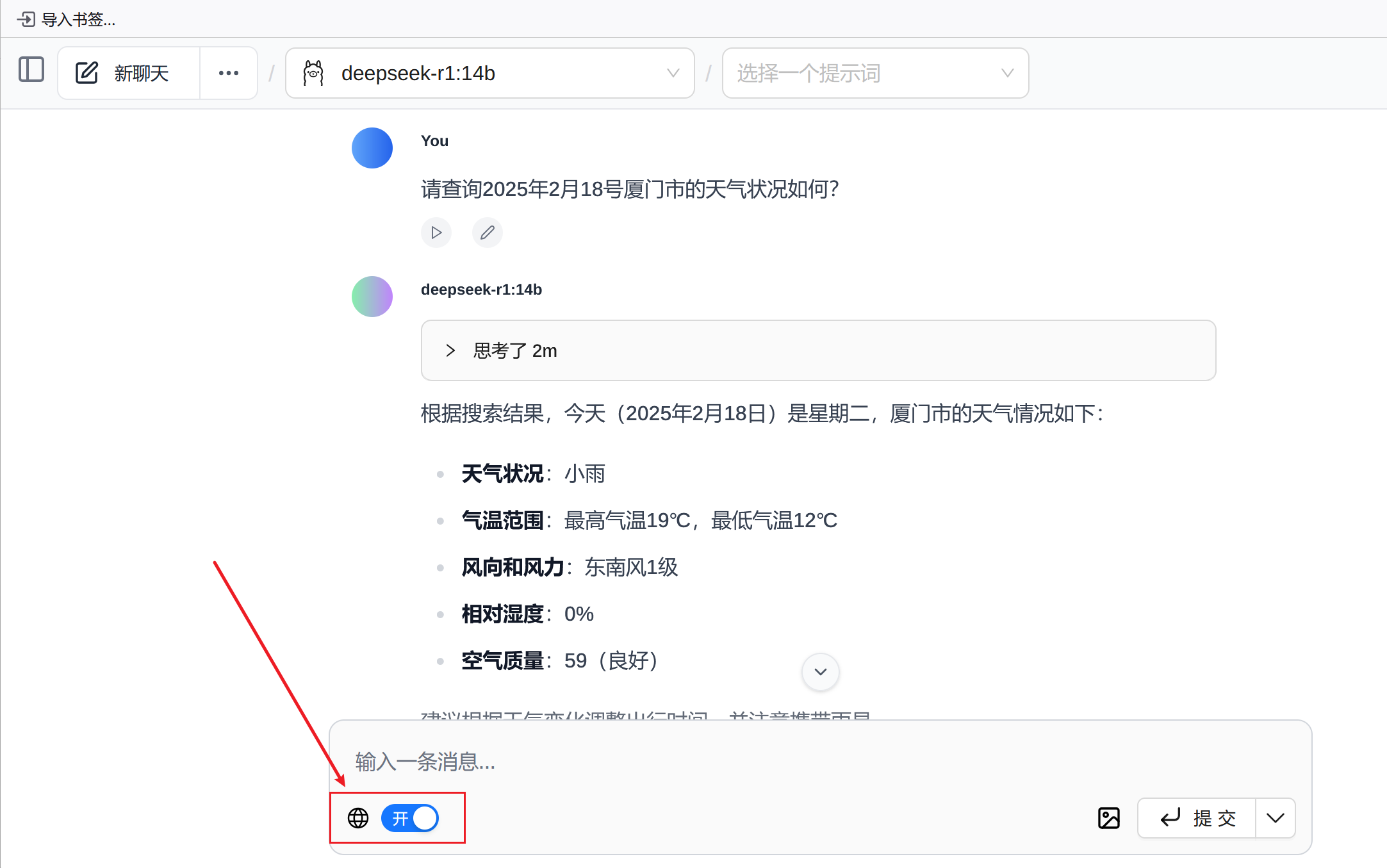

4、联网查询

注意:在联网查询时,输入问题后请将网络开关打开,敬候佳音即可

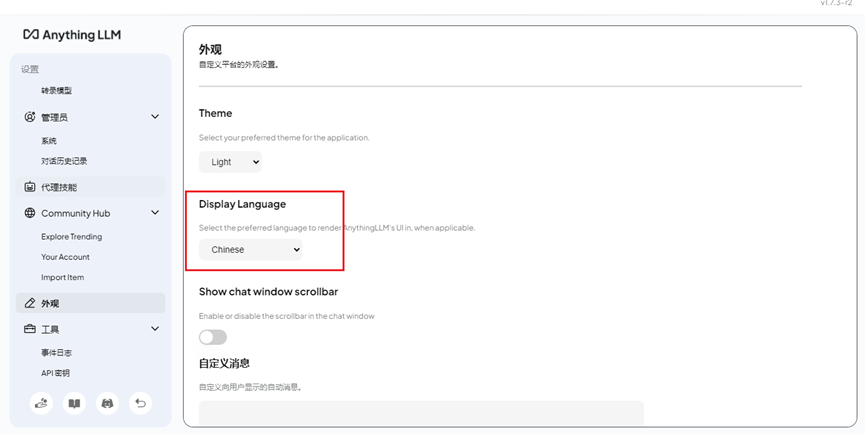

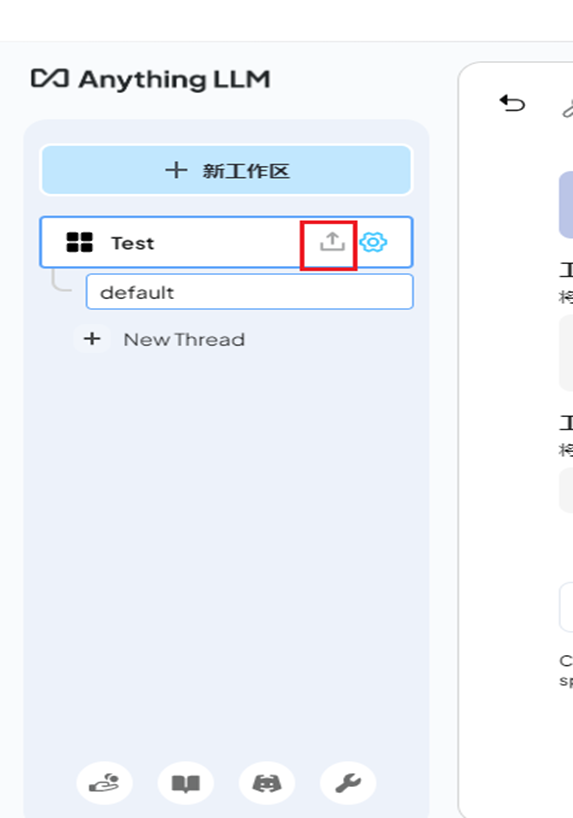

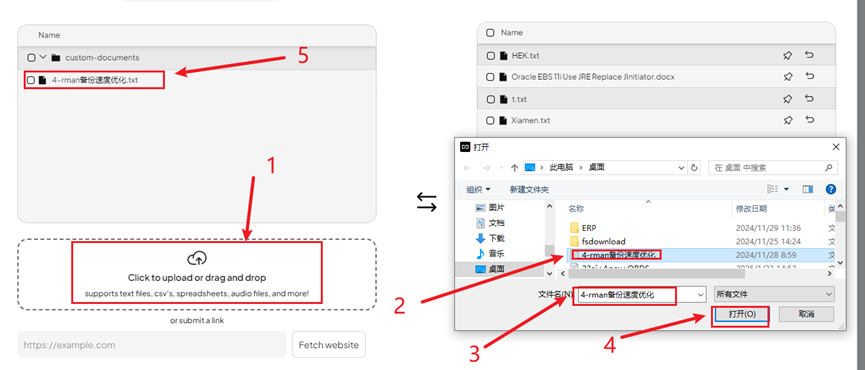

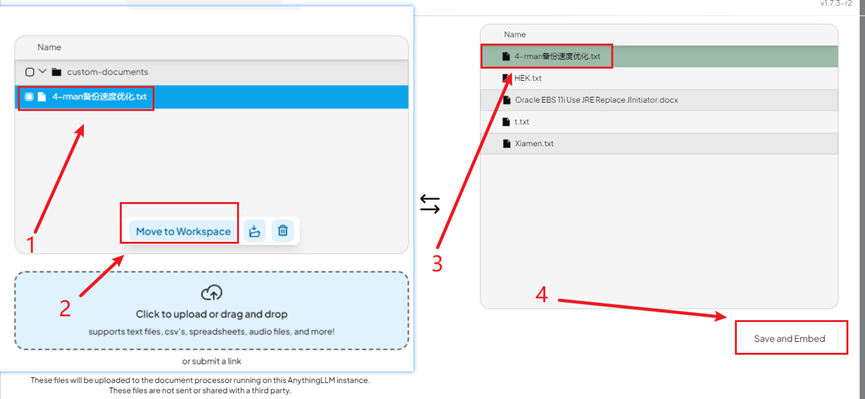

本地化知识库搭建

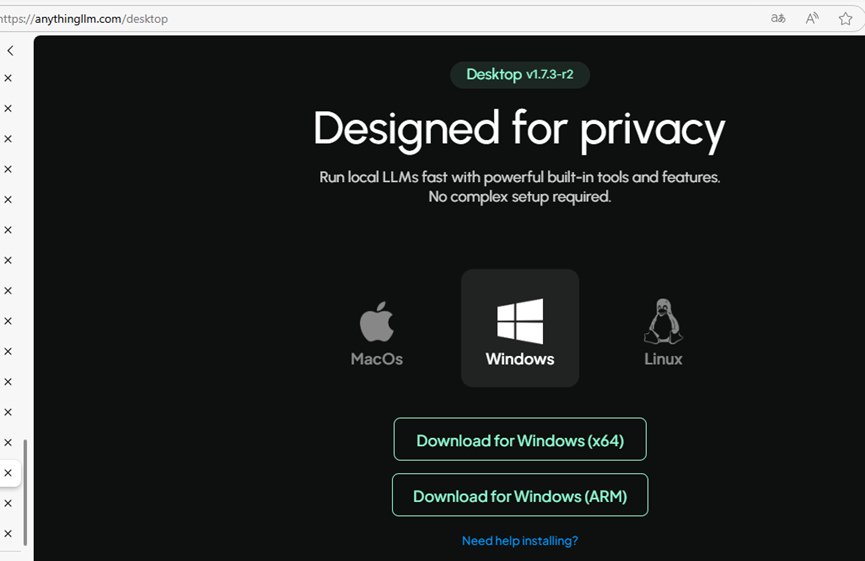

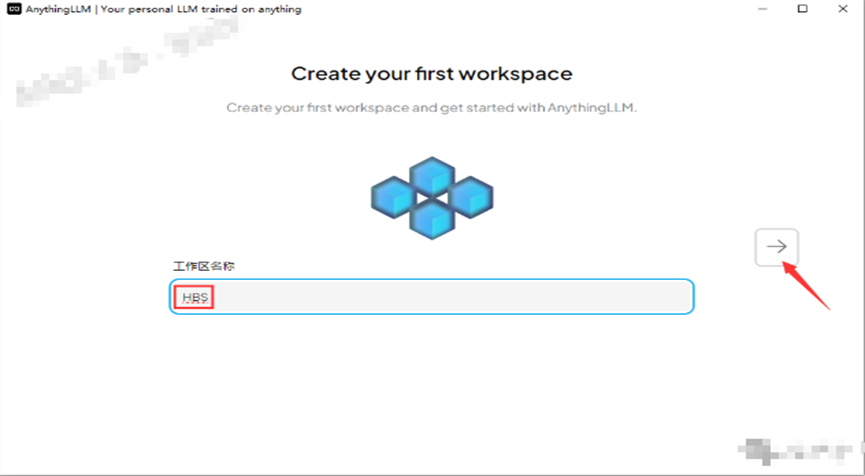

1、下载AnythingLLM

# 下载网址

https://anythingllm.com/desktop

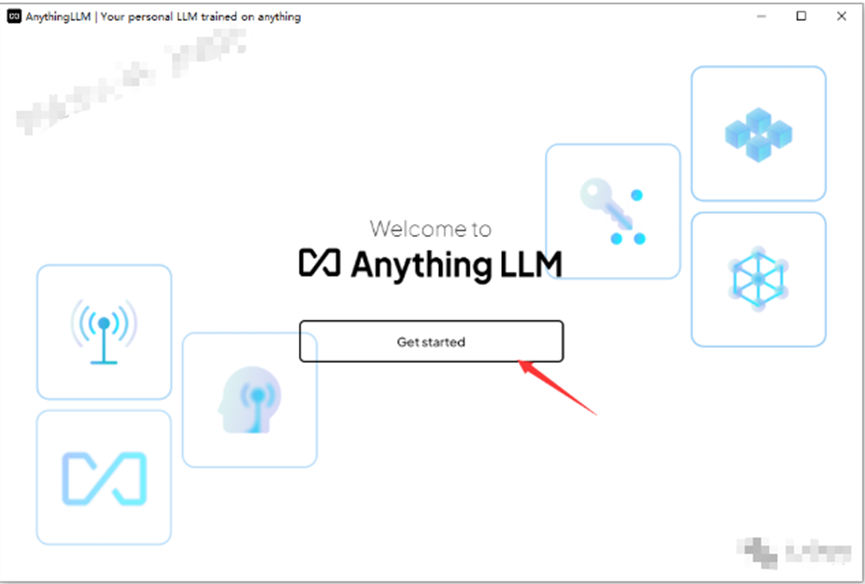

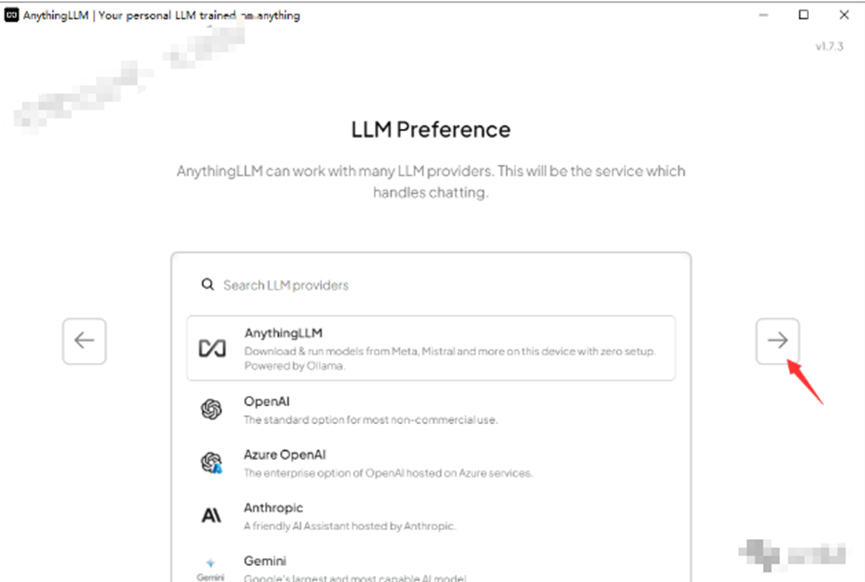

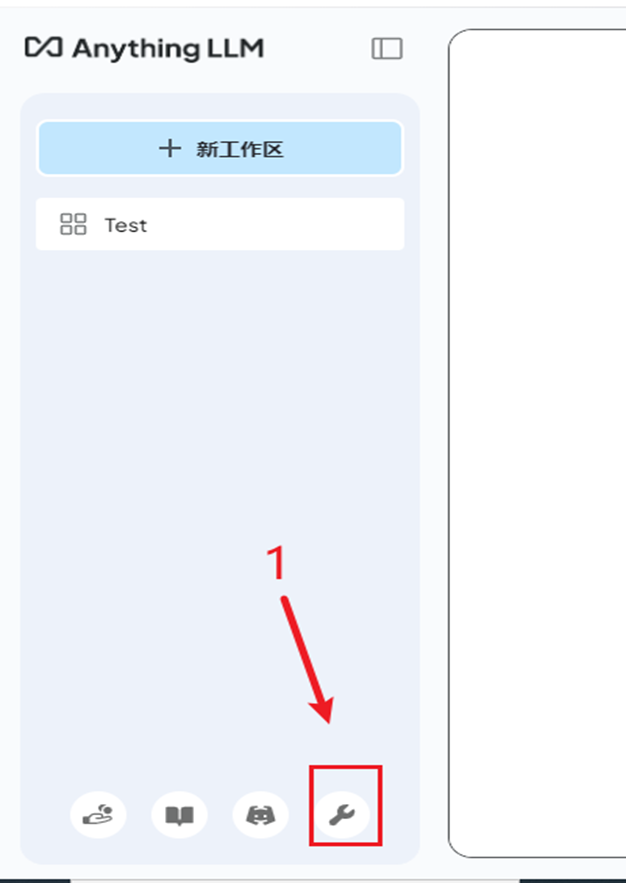

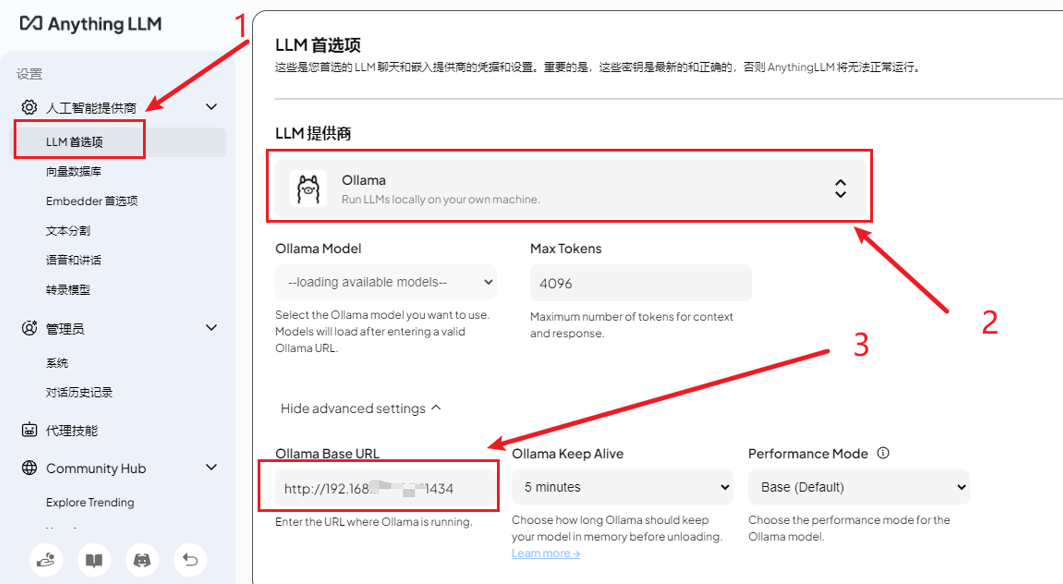

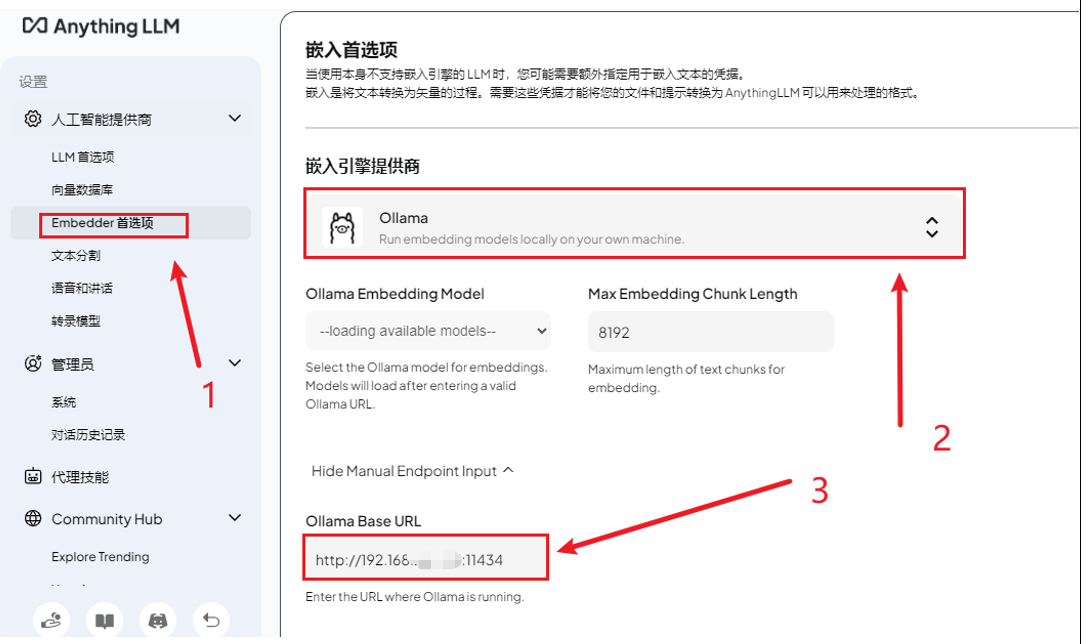

2、图片流程

2、训练测试

注意:在上传完文档后,根据文档内容进行提问即可

_web前端开发设计_荆州百度推广_百度一下首页手机版)

——鼠标模拟)