继续学习昨天的 基于MindNLP+MusicGen生成自己的个性化音乐

生成音乐

MusicGen支持两种生成模式:贪心(greedy)和采样(sampling)。在实际执行过程中,采样模式得到的结果要显著优于贪心模式。因此我们默认启用采样模式,并且可以在调用MusicgenForConditionalGeneration.generate时设置do_sample=True来显式指定使用采样模式。

无提示生成¶

我们可以通过方法 MusicgenForConditionalGeneration.get_unconditional_inputs 获得网络的随机输入,然后使用 .generate 方法进行自回归生成,指定 do_sample=True 来启用采样模式:

音频输出是格式是: a Torch tensor of shape (batch_size, num_channels, sequence_length)。

使用第三方库scipy将输出的音频保存为musicgen_out.wav 文件。

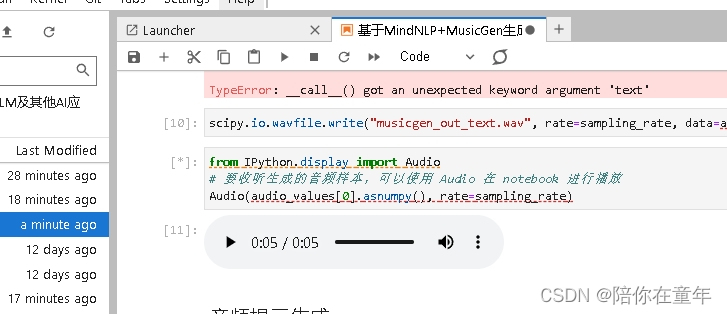

文本提示生成

首先基于文本提示,通过AutoProcessor对输入进行预处理。然后将预处理后的输入传递给 .generate 方法以生成文本条件音频样本。同样,我们通过设置“do_sample=True”来启用采样模式。

其中,guidance_scale 用于无分类器指导(CFG),设置条件对数之间的权重(从文本提示中预测)和无条件对数(从无条件或空文本中预测)。guidance_scale越高表示生成的模型与输入的文本更加紧密。通过设置guidance_scale > 1来启用 CFG。为获得最佳效果,使用guidance_scale=3(默认值)生成文本提示音频。

可能是算力不够,一直在运行,没有出结果。

不过经过等待终于出了点声音。

声音很短:只是5秒。但是的确是生成的。其他的代码运行还未结束。

_今日的最新消息_长沙官网seo收费标准)