目录

- 参考

- 业务需求

- 数据介绍

- 处理数据

- 导入数据

- 创建表

- 导入数据

- 查询前10条数据

- 查询前10个访问量最高的用户ID及访问数量,并按照访问量降序排列

- 分析链接排名与用户点击的相关性

- 分析一天中上网用户最多的时间段

- 查询同一个域名用户的点击数量最高的前10个

参考

https://www.bilibili.com/video/BV1qC4y1Y7ye?p=74&spm_id_from=pageDriver&vd_source=2030c834d24fc054a345b6d54b05edbe)

业务需求

使用搜狗实验室提供【用户查询日志(SogouQ)】数据,使用Hive,将数据封装到RDD中

进行业务数据处理分析。数据网址:http://www.sogou.com/labs/resource/q.php

- 查询前10条数据

- 查询前10个访问量最高的用户ID及访问数量,并按照访问量降序排列

- 分析链接排名与用户点击的相关性

- 分析一天中上网用户最多的时间段

- 查询同一个域名用户的点击数量最高的前10个

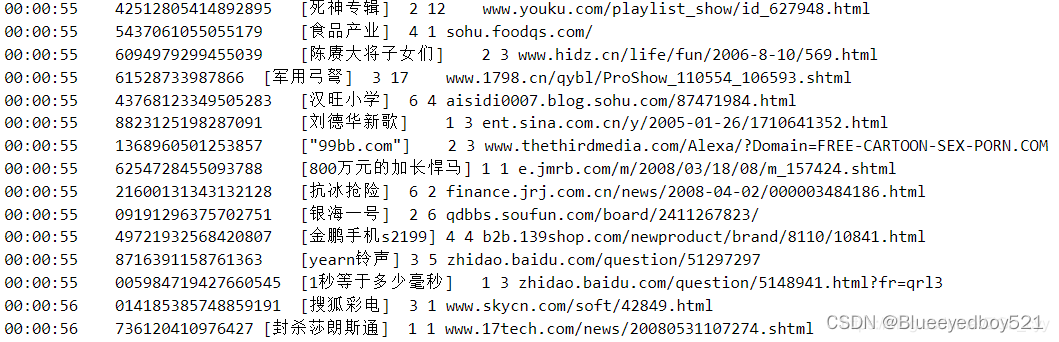

数据介绍

1)、数据介绍:搜索引擎查询日志库设计为包括约1个月(2008年6月)Sogou搜索引擎部分网页

查询需求及用户点击情况的网页查询日志数据集合。

2)、数据格式

访问时间\t用户ID\t[查询词]\t该URL在返回结果中的排名\t用户点击的顺序号\t用户点击的URL

处理数据

(2)将数据文件 SogouQ.reduced 的编码改为“utf-8”,然后保存。

(3)将文件 SogouQ.reduced上传到 Hive 所在服务器,例如上传到目录home/hadoop.进入数据文件所在目录,执行以下命令,将文件中的制表符和空格全部替换为英文逗号

$ sed -i "s/\t/,/g" SogouQ.reduced

$ sed -i "s/ /,/g" sogouQ.reduced

上述命令解析:

//替换掉ile文件所有的字符串

sed -i 's/原字符串/新字符串/g' file

(4)查看文件的前10条数据

head -10 SogouQ.reduced

导入数据

创建表

hive > create table activelog(time String, user_id string, keyword string, page_rank int ,click_order int ,url string)

> row format delimited fields terminated by ',';

导入数据

hive> load data local inpath '/opt/data/SogouQ.reduced' into table activelog;

查询前10条数据

查询前10个访问量最高的用户ID及访问数量,并按照访问量降序排列

hive> select user id,count(*)as num from activelog

> group by user id

> order by num desc

> limit 10;

分析链接排名与用户点击的相关性

select page_rank,count(*) as num from activelog

group by page_rank order by num desc

排名 点击次数

1 5645

2 4578

3 3242

由此可见,排名靠前的,点击次数越多

分析一天中上网用户最多的时间段

只需要时间段和访问量

select substr(time,1,2),count(*)as num from activelog group by substr(time,1,2) order by num desc limit 10:

查询同一个域名用户的点击数量最高的前10个

select substr(url,1,instr(url,"/")-1) hostname, count(*) num from activelog

gourp by substr(url,1,instr(url,"/")-1)

order by num desc

limit 10;

)